Du hast vor kurzem deinen neuen Shop online gestellt und wartest gespannt darauf, dass Kunden deine Produkte kaufen und die Kasse nur noch klingelt. Vergeblich.

Denn ohne die richtigen Maßnahmen wird nur durch Glück jemand auf deine Website stoßen. Die Lösung? SEO. Wenn du eine Website hast, wirst du an der Suchmaschinenoptimierung nicht vorbeikommen. Denn ohne SEO ist die Chance, ein gutes Ranking zu erhalten und somit Leads zu generieren, sehr gering.

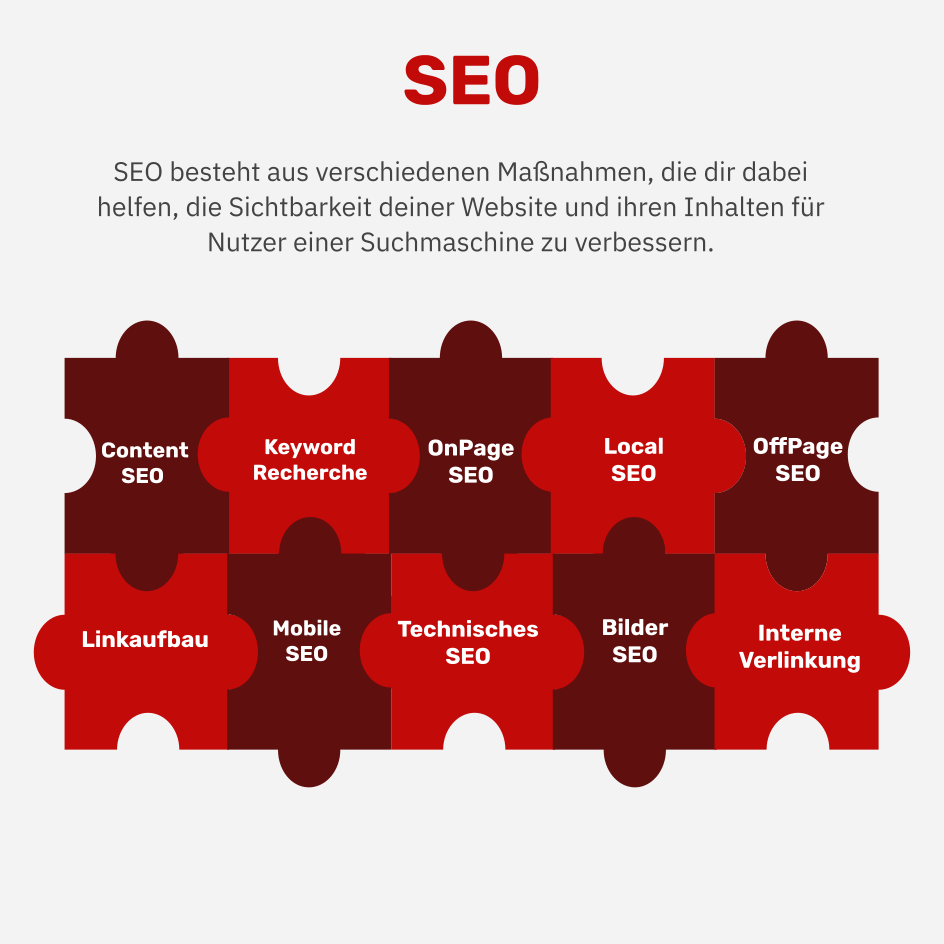

Was ist SEO?

SEO (Search Engine Optimization) ist die Verbesserung der Sichtbarkeit einer Website in den organischen Suchergebnissen (SERPs). Das Ziel bei der Suchmaschinenoptimierung ist also, in den Ergebnissen von Suchmaschinen wie Google, Bing und Co. für relevante Suchbegriffe besser gefunden und häufiger angeklickt zu werden.

Im gesamten Beitrag liegt der Fokus auf der Suchmaschine Google. Das ist aus zwei Gründen okay:

- Google hat in Deutschland mit Abstand den größten Marktanteil (über 90 Prozent).

- Andere Suchmaschinen funktionieren grundsätzlich genauso. Exakte Details zu den Algorithmen sind nicht bekannt – weder für Google noch für vergleichbare Suchmaschinen.

Bevor es darum geht, was du dafür tun kannst, damit eine Domain möglichst weit oben in den Suchergebnissen gefunden wird (das sogenannte Ranking), musst du zwei wichtige Grundlagen zur Funktionsweise von Suchmaschinen verstehen: Crawling und Indexing.

Crawling

Als Crawler oder Spider werden Bots bezeichnet, die Hyperlinks im World Wide Web folgen und somit eben wortwörtlich ein Netz aus verbundenen Online-Ressourcen erschließen. Dieses sogenannte Crawling wird auch von Suchmaschinen-Bots wie dem Googlebot durchgeführt, um neue oder aktualisierte Seiten im Internet zu finden. Bei Bedarf werden diese Seiten dann zum Suchmaschinenindex hinzugefügt (Indexierung, siehe unten).

Steuern lässt sich das Crawling der jeweiligen Domain durch Bots mit der robots.txt-Datei. Diese kann als Textdatei unter dem Pfad /robots.txt (also: https://www.example.com/robots.txt) für eine Subdomain hinterlegt werden und enthält Anweisungen jeweils in einer einzelnen Zeile.

Diese sind folgendermaßen aufgebaut:

- User-Agent: Damit können Anweisungen speziell für bestimmte User-Agents angelegt werden, zum Beispiel „User-agent: Googlebot” für Anweisungen, die nur für Googles Crawler gelten sollen.

- Disallow: Verbietet Crawlern den Zugriff auf bestimmte Website-Bereiche oder einzelne URLs.

- Allow: Erlaubt Crawlern den Zugriff auf bestimmte Website-Bereiche oder einzelne URLs. Überschreibt im Zweifelsfall eine vorangegangene Disallow-Anweisung.

- Sitemap: Zeigt die Adresse der Sitemap(s) beziehungsweise der Sitemap-Index-Datei an.

Warum solltest du überhaupt Website-Bereiche vom Crawling ausschließen?

In der Praxis werden auf vielen Websites URLs generiert, die keinen wirklichen Mehrwert bieten oder die einfach nicht dafür bestimmt sind, in den organischen Suchergebnissen gefunden zu werden (etwa Landingpages für andere Online-Marketing-Kanäle).

Bei großen Websites kann das dazu führen, dass die Grenze des Crawling-Budgets erreicht wird – also die maximale Anzahl an URLs, die der Googlebot in einem bestimmten Zeitraum aufrufen kann. Um diese Kapazität auf die wichtigen Website-Bereiche zu konzentrieren und Crawling und Indexierung von neuen Seiten zu beschleunigen, sollten irrelevante Inhalte auf der Domain für Suchmaschinen gesperrt werden.

Tooltipp

Indexierung

Webseiten, die Google gecrawlt und für relevant befunden hat, werden in den Suchmaschinenindex aufgenommen. Im Indexeintrag wird der jeweilige Inhalt beschrieben und die URL angegeben.

Ob sich eine bestimmte URL im Google-Index befindet, lässt sich am schnellsten mit einer Google-Suche nach site:URL herausfinden. Resultiert hier kein Suchergebnis, ist die URL nicht im Index der Suchmaschine enthalten.

Die Indexierung ist abhängig vom Crawling, aber keinesfalls damit gleichzusetzen. Es kann beispielsweise passieren, dass URLs indexiert werden, die via robots.txt-Datei vom Crawling ausgeschlossen sind, weil Google sie trotzdem für relevant genug hält (siehe unten, Ranking-Signale, speziell Backlinks).

Die Indexierung kann mittels Noindex-Anweisung blockiert werden, entweder im Meta-Tag im HTML-Quellcode (<meta name=“robots“ content=“noindex“>) oder per X-Robots-Tag im HTTP-Antwortheader (X-Robots-Tag: noindex).

Ein Canonical-Tag mit Verweis auf eine andere URL als Originalversion verhindert die Indexierung durch Suchmaschinen ebenfalls. Im Fall von unterschiedlichen erreichbaren URLs, die den identischen Inhalt besitzen, ist dieses Tag die bessere Wahl.

Warum solltest du überhaupt Website-Bereiche von der Indexierung ausschließen?

In manchen Fällen dürfen URLs nicht über die Ergebnisse von Suchmaschinen erreichbar sein (zum Beispiel aus datenschutzrechtlichen Gründen). Oder es gibt kein gutes URL-Kriterium, um bestimmte Seitentypen per robots.txt-Datei vom Crawling auszuschließen.

Es ist aber leicht möglich, sie automatisiert mit einem RobotsMeta-Noindex-Tag zu versehen – als Alternative zum Ausschluss vom Crawling wäre das allerdings nur zu empfehlen, wenn das Crawl-Budget keine Bedeutung hat (siehe oben).

Tooltipp

Ranking

Die Verantwortlichen bei Google verkündeten bereits 2010, dass es über 200 verschiedene Rankingfaktoren gibt, aus denen viele ineinandergreifende Algorithmen die Reihenfolge der Suchergebnisse errechnen.

Das Ziel dieses riesigen Aufwandes ist und bleibt die Zufriedenheit der Nutzer, denn Google möchte ja, dass möglichst viel gegoogelt wird – und bloß keine andere Suchmaschine zum Einsatz kommt. Doch natürlich sind nicht all diese Signale gleich wichtig. Im Folgenden geht es daher um die drei wichtigsten Rankingfaktoren.

Tipp: Um die Rankings einer Website zu veranschaulichen, zu analysieren und zu überwachen, sind Sichtbarkeits-Index-Tools wie SISTRIX, Xovi, Searchmetrics, SEMrush und viele andere gut geeignet.

Content

In allererster Linie besteht die Aufgabe einer Suchmaschine darin, Inhalte zu finden, die zu der Suchanfrage passen. Wenn die Suchanfrage beispielsweise „T-Shirt mit Pandabär-Motiv” lautet, werden Nutzer mit Panda-Bettwäsche genauso unzufrieden sein wie mit T-Shirts, die mit Katzen bedruckt sind. Als Website-Betreiber oder SEO-Beauftragter solltest du der Suchmaschine also möglichst passend und umfassend signalisieren, was genau auf deiner Website zu finden ist (mehr dazu unter Onpage-SEO, siehe unten).

Und wenn du für Suchanfragen wie „Kann ich einen Panda als Haustier halten?“ bei Google ganz oben gefunden werden willst, musst du den besten Inhalt dazu anbieten – nicht mehr und nicht weniger.

Backlinks

Ein weiteres wichtiges Rankingsignal sind Links, die von anderen Domains auf eine Domain beziehungsweise deren Unterseiten zeigen. Dabei geht es nicht nur um die reine Anzahl, sondern vor allem um die Qualität und thematische Relevanz der Backlinks.

Am wertvollsten sind also Links von vertrauenswürdigen Websites mit Autorität zum Thema (mehr dazu unter Offpage SEO, siehe unten).

Page Experience

Zunehmende Bedeutung haben diverse Faktoren, die gemeinsam dazu beitragen, dass die Nutzererfahrung möglichst angenehm ist – für Besucher am Desktop-PC, am Tablet oder am Smartphone gleichermaßen. Zu nennen wären da insbesondere die Ladezeit (Page Speed), die Mobiltauglichkeit und die Sicherheit der Website.

Onpage SEO

Wie der Name vermuten lässt, geht es bei der Onpage SEO darum, alle Aspekte auf der Seite selbst zu optimieren. Es gilt also zunächst, neue Seiten aufzubauen oder bestehende so anzupassen, damit sie möglichst gut für interessante Suchbegriffe (Keywords) gefunden werden.

Wenn das schon zu einem gewissen Grad gelingt, kannst du mit Onpage SEO darüber hinaus dafür sorgen, dass die Suchergebnisse attraktiver aussehen und/oder mehr Raum einnehmen, damit sie häufiger angeklickt werden.

Keywords, Keywords, Keywords

Suchmaschinennutzer starten ihre Suche mit der Eingabe einer Suchanfrage. Für diese Suchanfragen möchtest du als SEO-Verantwortlicher die passende Seite auf einer Domain optimieren. Dafür nutzt du das Keyword in Überschriften, in Texten, im Seitentitel und in der Meta-Beschreibung. Studien zeigen, dass Suchanfragen häufig aus drei und mehr Wörtern bestehen.

Seiten sollten daher nicht nur auf ein Haupt-Keyword optimiert werden, sondern eine Vielzahl von Keywords abdecken. Dazu können alternative Begriffe und Fragestellungen in Texten verarbeitet werden.

Keywords werden unterschiedlich häufig gesucht. Die, die ein hohes Suchvolumen aufweisen, werden auch Head Keywords genannt. Ein deutlich geringeres Suchvolumen gibt es bei sehr spezifischen Suchbegriffen und längeren Phrasen. Sie werden als Long Tail Keywords bezeichnet. Long Tail Keywords sind besonders spannend, weil es in der Regel weniger Konkurrenz dafür gibt, der Klick wahrscheinlicher ist und durch die genaue Suchanfrage die Chance auf eine Conversion höher ist.

Bei der Keyword-Recherche geht es ergo nicht nur um das Suchvolumen, also die Frage, wie häufig ein bestimmter Begriff bei Suchmaschinen eingegeben wird. Die Suchintention ist von entscheidender Bedeutung. Warum hat der Nutzer die Suchanfrage gestellt? Was muss nach dem Klick auf ein Suchergebnis geschehen, damit der Nutzer zufrieden ist?

Grundsätzlich lassen sich Keywords da in drei Kategorien unterteilen:

- Informational: Der Nutzer möchte etwas wissen, eine Frage beantworten oder einen Fakt nachschlagen.

- Transaktional: Der Nutzer möchte etwas tun, etwa kaufen, anfragen, buchen etc.

- Navigational: Der Nutzer sucht nach einer bestimmten Website oder Adresse.

Als Keyworddichte wird angegeben, wie häufig ein Keyword in einem Text im Verhältnis zu dessen Länge des Textes genannt wird. Bei einer Keyworddichte von 3 Prozent müsste das Keyword in 100 Wörtern also dreimal vorkommen.

Keywords sollten sinnvoll in Texten genutzt werden, aber sogenanntes Keyword Stuffing, also das übertrieben häufige Nennen von Suchbegriffen ohne textlichen Zusammenhang, muss unbedingt vermieden werden. Texte sollten gut leserlich und inhaltlich wertvoll sein. Es gibt hier keine goldene Regel zur Keyworddichte. Im Gegenteil: Bei einer Keyworddichte über 5 Prozent solltest du skeptisch werden und Texte auf ihre Qualität hin prüfen – ganz ohne SEO-Brille. Andere Faktoren sind inzwischen viel wichtiger.

Im Zusammenhang mit Keywords und suchmaschinenoptimierten Texten wirst du früher oder später den Begriff WDF*IDF hören (within document frequency * inverse document frequency).

Die WDF*IDF-Formel gibt an, in welchem Verhältnis Keywords in einem Text oder auf einer Website im Vergleich zu anderen Dokumenten vorkommen, etwa den Top-10-Suchergebnissen. WDF*IDF-Tools ermitteln darauf basierend, welche Keywords im Text noch vorkommen sollten.

Die Ergebnisse dieser Tools sind nicht perfekt. Idealerweise betrachtest du sie mit gesundem Menschenverstand als Vorschläge und keinesfalls als strenge Vorgabe für SEO-Texte.

Tooltip

Auch die Google-Suche selbst ist eine Quelle bei der Keyword-Recherche: Zu jeder Suchanfrage bietet Google bereits bei der Eingabe einer Suchanfrage Vorschläge an (Google Suggest). Tools wie answerthepublic.com sammeln diese automatischen Ergänzungen von Google zum gewünschten Keyword und geben sie gesammelt aus. Ganz unten auf der Suchergebnisseite zeigt Google außerdem verwandte Suchanfragen an, die Inspirationen liefern können.

Alle Keyword-Ideen einer Suchergebnisseite lassen sich am einfachsten mit dem kostenlosen Browser-Plugin „SERP Keyword Scraper“ einsammeln (für Chrome und Firefox).

SERP-Optimierung

Wenn du nun ein Ranking auf der Suchergebnisseite (SERP, auf Englisch: search engine results page) erreicht hast, fehlt nur noch ein Schritt, um Besucher auf die Website zu locken: der Klick.

Zur Steigerung der Klickrate, also dem Anteil der Suchenden, die das Suchergebnis nicht nur sehen, sondern es auch anklicken, lassen sich einige Maßnahmen ergreifen. Dafür musst du zunächst wissen, wie einzelne Suchergebnisse aufgebaut sind.

Der Seitentitel (HTML =<title>) stellt eines der wichtigsten Rankingkriterien dar und sollte daher das wichtigste Keyword enthalten. Er sollte 50 bis 60 Zeichen lang sein. Er wird als blaue Überschrift dargestellt.

Daneben fällt auch eine gute Meta-Beschreibung als grauer Snippet-Text darunter ins Auge (HTML = <meta name=“description“>). Auch wenn die hier genutzten Keywords keine Bedeutung für das Ranking haben, werden sie fett dargestellt und signalisieren dem Nutzer, dass das Suchergebnis zur Anfrage passt.

Hier sollten auch unbedingt Argumente aufgenommen werden, warum genau dieses Suchergebnis das beste ist. Sonderzeichen wie Häkchen, Herzen oder Emojis können die Auffälligkeit erhöhen, sie sollten jedoch nur in Maßen eingesetzt werden. Die Meta-Beschreibung sollte 130 bis 150 Zeichen lang sein. Sowohl Seitentitel als auch Meta-Beschreibung sollten einzigartig sein, also für jede URL unterschiedlich.

Darüber hinaus gibt es diverse Elemente, mit denen Google die Suchergebnisse inzwischen anreichert, zum Beispiel Preise, Verfügbarkeit, Bewertungssterne, Zeit und Datum bei Veranstaltungen etc. Diese Informationen erkennt Google teils schon komplett selbstständig auf der Website. Du kannst dabei helfen und deine Chance auf klickbarere Suchergebnisse erhöhen, indem strukturierte Daten mit Markup maschinenlesbar ausgezeichnet werden.

Offpage SEO

Mit Offpage SEO, also Maßnahmen abseits der eigenen Site, ist in der Regel der gezielte Aufbau und die Optimierung von Backlinks gemeint – also Hyperlinks von anderen Domains.

Nachdem Google 1997 die Betrachtung von Links als Empfehlungen und somit ein revolutionäres Rankingsignal einführte (Stichwort PageRank), stieg die Suchmaschine dank der hervorragenden Qualität der Suchergebnisse schnell zum Weltmarktführer auf. Gleichzeitig dauerte es nicht lange, bis Suchmaschinenoptimierer und Website-Betreiber dieses Kriterium gezielt manipulierten.

Inzwischen hat Google durch Algorithmus-Updates und menschliche Qualitätsprüfer das Problem von Spam-Links einigermaßen eingedämmt. Wer gegen Googles Spielregeln verstößt, setzt sich der Gefahr aus, die gesamte Sichtbarkeit in den Suchergebnissen durch eine Abstrafung (Penalty) zu verlieren.

Wenn du also Links aufbauen möchtest, die langfristig sicher sind und einer Website nachhaltig dabei helfen, gute Suchmaschinen-Rankings zu erzielen, solltest du zunächst die Google-Richtlinien kennen.

Die wichtigsten Verbote zu Backlinks darin sind folgende:

- Kauf oder Verkauf von Links (auch Anzeigen, Banner, Native Advertising, Sponsored Posts, Advertorials etc.)

- Exzessiver Linktausch

- Artikel-Marketing im großen Stil (Gastartikel mit Keyword-Links)

- Automatisierte Programme und Dienste, die Links zu einer Website erstellen

- Pressemitteilungen mit Links, die Suchbegriffe im Linktext enthalten

- Links von Verzeichnissen oder Lesezeichen-Websites geringer Qualität

- Links aus Widgets, die auf anderen Websites verteilt sind

- Links aus den Fußzeilen verschiedener Websites

- Kommentare in Foren oder unter Blogbeiträgen mit Links im Post oder der Signatur

- Versteckte Links

Dabei geht es immer explizit um Backlinks, die PageRank weitergeben. Natürlich verbietet Google nicht alle Advertorials, Werbebanner, Widgets etc., die einen Link enthalten – diese Links müssen allerdings mit dem Nofollow-Attribut versehen werden, damit nicht gegen Googles Richtlinien verstoßen wird. Dieses Tag signalisiert Suchmaschinen, dass ein bestimmter Link (oder alle ausgehenden Links einer URL) als Rankingsignal ignoriert werden soll.

Ankertexte

Der Ankertext (auch Linktext) ist der Text, der als Link für Nutzer sichtbar dargestellt wird. Für den Suchmaschinen-Algorithmus sind Ankertexte von eingehenden Links ein wichtiges Signal, was auf der jeweiligen Website zu finden ist. Allerdings musst du heutzutage aufpassen, dass die Gesamtheit der Backlinks (das sogenannte Linkprofil) keine Muster enthält, die auf Manipulation hindeuten – wie beispielsweise auffällig viele Links mit Keywords im Ankertext (sogenannte Keyword-Links). Natürlicher wirken längere Ankertexte aus Phrasen, die beispielsweise auch den Namen der Website enthalten.

Interne Verlinkung

Mit interner Verlinkung sind Links von einer URL auf eine andere URL auf derselben Domain gemeint. Durch diese internen Links kann Suchmaschinen ein starkes Signal gegeben werden, welche Unterseiten einer Website für welche Themen wichtig sind.

Am Beispiel: Wenn es auf deiner Website eine Seite mit Panda-T-Shirts gibt, zeigst du Suchmaschinen den Weg dorthin mit internen Links. Wenn diese Links außerdem einen sinnvollen Ankertext haben – umso besser. Bei internen Links dürfen ohne Hemmungen Keyword-Links gesetzt werden.

Tooltipp

Vor allem zur Konkurrenzanalyse kann man Linkdatenbanken dennoch gut nutzen: Wer verlinkt bereits auf deine Wettbewerber? Kannst du aus den Link-Strategien anderer Unternehmen etwas ableiten? Auch die Qualität einer potenziell verlinkenden Website beim Linkaufbau kannst du so bewerten: Wie gut ist die Website verlinkt? Lohnt es sich, dort wegen einer Verlinkung anzufragen? Wie viel wäre so ein Link im Zweifel wert (obwohl Linkkauf natürlich in der Theorie verboten ist, siehe oben)?

Weitere SEO-Themen

In diesem Beitrag hast du nun die wichtigsten Basics zur Suchmaschinenoptimierung kennengelernt. Im Rahmen dieses Beitrags kann das Thema SEO natürlich nicht erschöpfend behandelt werden – denn allein dazu wurden schon sehr dicke Bücher geschrieben (Empfehlung für Interessierte: Suchmaschinen-Optimierung: Das umfassende Handbuch von Sebastian Erlhofer). Wegen ihrer von Website zu Website stark unterschiedlichen Relevanz seien hier aber folgende Unterthemen der SEO mit jeweils einem Literaturtipp erwähnt:

• International SEO: für Websites, die auch in anderen Ländern und auf anderen Sprachen gefunden werden sollen. Buch: International SEO: Der Kompakt-Ratgeber rund um hreflang, Domain-Strategien, Tools + mehr von Markus Hövener.

• Local SEO: für Websites, die insbesondere lokal gefunden werden sollen, also mit physischen Adressen als Verkaufsstellen oder für Dienstleistungen (Filialen, Restaurants, Ärzte, Fitnessstudios etc.). Lesetipp: Local SEO: Grundlagen & Tipps für die lokale Suche.

• Bilder-SEO: E-Book Bilder SEO 2018 von Martin Mißfeldt.

Fazit

Das komplexe Feld der Suchmaschinenoptimierung entwickelt sich mit den Anforderungen von Nutzern und Suchmaschinen an moderne Websites stetig weiter. Die Investition in die nachhaltige Reichweite über Suchergebnisse und damit den langfristigen Erfolg einer Website zahlt sich meistens aus – auch wenn dafür Expertenwissen und Fleißarbeit nötig sind.

Häufig gestellte Fragen zu SEO

An dieser Stelle beantworten wir die am häufigsten gestellten Fragen zu SEO.

Was ist ein Beispiel für SEO?

Ein Beispiel für eine Suchmaschinenoptimierung ist das Einpflegen eines Fokus-Keywords an verschiedenen Stellen einer Unterseite. Das heißt, das Keyword wird im Titel, in verschiedenen Überschriften, Bildern und im Text erwähnt, sodass die Seite auf Suchmaschinen-Rankings weiter oben steht.

Was gehört alles zu SEO?

Zu SEO gehören das Keywording, die On- und Offpage-Optimierung, die Optimierung der mobilen Ansicht, die Erfolgsmessung mit KPIs und die technische SEO. Also jegliche Maßnahmen, die die Position deiner Inhalte auf Suchmaschinen verbessern.

Ist SEO schwer?

Nein, SEO ist nicht so schwer, besonders für Personen, die sich mit dem Thema bereits auseinandergesetzt haben. Wie bei den meisten Dingen, braucht es aber Geduld, um SEO gut zu meistern. Suchmaschinenoptimierung ist schließlich eine Reihenfolge von Maßnahmen, kein Quick Fix.

Wie kann SEO am besten erlernt werden?

Am besten lernst du SEO durch das Lesen von Fachliteratur und durch die praktische Anwendung. Es gibt viele kostenlose Online-Ressourcen, die den Einstieg in SEO erleichtern. Es ist auch hilfreich, sich mit anderen SEO-Experten auszutauschen und auf dem Laufenden zu bleiben.

Wie viel kostet SEO?

Wie viel SEO kostet, ist von verschiedenen Faktoren abhängig. Beauftragt man eine SEO Agentur, liegt man oft bei einem durchschnittlichen Stundenlohn von 120 EUR. Die Kosten hängen vom Stundenlohn und von den Stunden, die die Agentur für sämtliche Aufgaben aufwenden muss, ab.

Welche SEO-Agenturen sind die besten in Deutschland?

In Deutschland gibt es eine Vielzahl von SEO-Agenturen. Zu den zehn Meistgenutzten zählen SEO-Küche Internet Marketing, Seokratie, morefire, SUMAX SEO AGENTUR, luna-park, diva-e Advertising, Suchhelden, Online Solutions Group, ALMARON und SEMTRIX.

- Search Engine Market Share Germany Nov 2020 - Nov 2021

- Schmidt: Listing Google’s 200 Ranking Factors Would Reveal Business Secrets

- The State of Searcher Behavior Revealed Through 23 Remarkable Statistics

- Top Bing Searches (2021)

- Strukturierte Daten: Markup-Hilfe

- Richtlinien für Webmaster

- Ausgehende Links für Google eingrenzen